В последнюю неделю марта 2023 почти 2,5К выдающих представителей различных сфер — в том числе Илон Маск, Стив Возняк, Кристоф Кох — подписали открытое письмо за приостановку экспериментов с искусственным интеллектом (Artificial Intelligence, AI).

Поскольку развитие ИИ влияет и на покер — большинство современных солверов и другие инструменты для игроков используют его для расчётов по спотам — в рамках совместного проекта Покерофф и ПокерОК мы решили углубиться в эту тему, взглянув на возможные риски и положительные стороны для разных сфер человеческой жизни.

Открытое письмо, адресованное AI лабораториям

Оригинал текста письма под заголовком «Остановите гигантские эксперименты с ИИ: открытое письмо» (Pause Giant AI Experiments: An Open Letter) можно найти на сайте некоммерческой организации «Future of Life Institute».

Письмо довольно большое — ниже вы найдёте его полный перевод на русский язык. Если обобщить его содержание, то текст:

- Указывает на основные риски идущей сейчас гонки развития систем ИИ;

- Предлагает посмотреть на использование таких систем с точки зрения потенциального вреда обществу;

- Обозначает основные проблемы контроля, управления и распространения ИИ;

- Описывает в общих чертах пути решения этих проблем.

Полный перевод письма на русский язык

Прежде, чем переходить к тексту, ознакомьтесь с понятиями:

- Asilomar AI Principles — 23 принципа работы с искусственным интеллектом, которые были разработаны и утверждены ведущими представителям сферы, чтобы предупредить риски. Ознакомиться с ними на русском языке можно через сайт Future of Life Institute;

- GPT-4 — так в тексте называют последнюю версию нейросети Chat GPT от OpenAI, в которой используются одни из наиболее продвинутых технологий ИИ;

- OpenAI — компания-разработчик, специализирующаяся на технологиях машинного обучения и развития нейросетей.

Некоторые места мы переформатировали по оформлению, чтобы текст было легче читать:

Обширные исследования показывают, что системы ИИ, интеллект которых конкурирует с людским, могут представлять серьёзную опасность для общества и человечества — и топовые лаборатории ИИ признают это. Как определяют Asilomar AI Principles, продвинутый ИИ может привести к глубоким изменениям в истории жизни на Земле, поэтому он должен быть спланирован и использован тщательно, с большой аккуратностью и учётом доступных ресурсов. К сожалению, такого уровня планирования и управления в настоящий момент не существует, даже несмотря на то, что в последние месяцы лаборатории ИИ застряли в бесконтрольной гонке по разработке и развертыванию всё более мощных цифровых умов, результатов работы которых никто — даже их разработчики — не может понять, предсказать или контролировать должным образом.

Современные системы ИИ способны соревноваться с людьми в решении общих задач, но мы должны спросить себя:

- Стоит ли нам позволять машинам наполнять информационные каналы пропагандой и неправдой?

- Стоит ли нам автоматизировать все работы, в том числе приносящие людям удовлетворение?

- Стоит ли нам развивать нечеловеческие умы, которые в итоге могут перехитрить нас, превзойти численностью и заменить?

- Стоит ли нам рисковать потерей контроля над нашей цивилизацией?

Такие решения не должны делегироваться неизбранным лидерам технологического сектора. Мощные системы ИИ должны разрабатываться только тогда, когда мы уверены в положительности их эффектов и управляемости рисков. Эта уверенность должна иметь хорошее обоснование и повышаться вместе с величиной потенциальных эффектов использования системы. В недавнем заявлении OpenAI по поводу искусственного общего интеллекта говорится: «В какой-то момент может оказаться важным получить независимую оценку состояния действующих систем ИИ до того, как приступать к обучению новых, чтобы ограничить скорость роста вычисления для создания новых моделей». Мы согласны. Сейчас — тот самый момент.

С учётом всего вышесказанного, мы призываем все лаборатории ИИ немедленно поставить на паузу как минимум в 6 месяцев обучение систем искусственного интеллекта, которые по мощности превышают GPT-4. Эта пауза должна быть публичной, проверяемой и принятой всеми ключевыми участниками процесса. Если ввести её быстро нельзя, то правительства стран должны вмешаться в ситуацию и ввести мораторий.

Лаборатории ИИ и независимые эксперты должны воспользоваться паузой, чтобы заняться совместной разработкой протоколов безопасности для усовершенствованного проектирования и разработки искусственного интеллекта, причём эти протоколы должны будут тщательно проверяться и контролироваться независимыми экспертами извне. Такие протоколы должны гарантировать, что системы, по которым они работают, безопасны вне всяких сомнений. Это не значит паузу в развитии ИИ в целом, но подразумевает шаг назад от опасной гонки, которая ведёт к всё более непредсказуемым моделям ИИ по типу «чёрного ящика» с постоянно расширяющимися возможностями.

Исследования и разработки в области ИИ должны сместить фокус на то, чтобы сделать уже существующие современные системы более безопасными, понятными, точными, прозрачными, надежными, заслуживающими доверия и лояльными.

Параллельно, разработчики ИИ должны работать над значительным ускорением разработки надёжных систем управления искусственным интеллектом. Они должны как минимум включать:

- Новые и подходящие для этого регулирующие органы, занимающиеся вопросами ИИ;

- Отслеживание и надзор за работой высокопроизводительных систем ИИ и крупных пулов вычислительных мощностей;

- Маркировку происхождения и использование водяных знаков для помощи в различении реальных систем ИИ от подделок и поиске утечек;

- Надежную экосистему аудита и сертификации;

- Определение ответственности за ущерб, нанесённый искусственным интеллектом;

- Надёжное государственное финансирование технических исследований безопасности ИИ;

- Хорошо подготовленные институты для преодоления серьёзных экономических и политических потрясений (особенно для демократии), которые вызовет ИИ.

Человечество может наслаждаться прекрасным будущим с искусственным интеллектом. Добившись успеха в создании мощных систем ИИ, мы можем наслаждаться «летом ИИ», во время которого мы пожинаем плоды, развиваем эти системы для общего блага и даём обществу шанс адаптироваться. Общество уже приостановило другие технологии, которые потенциально могли оказать катастрофический эффект на него. Мы тоже можем сделать это. Давайте наслаждаться долгим летом ИИ, не торопясь попасть в осень без подготовки.

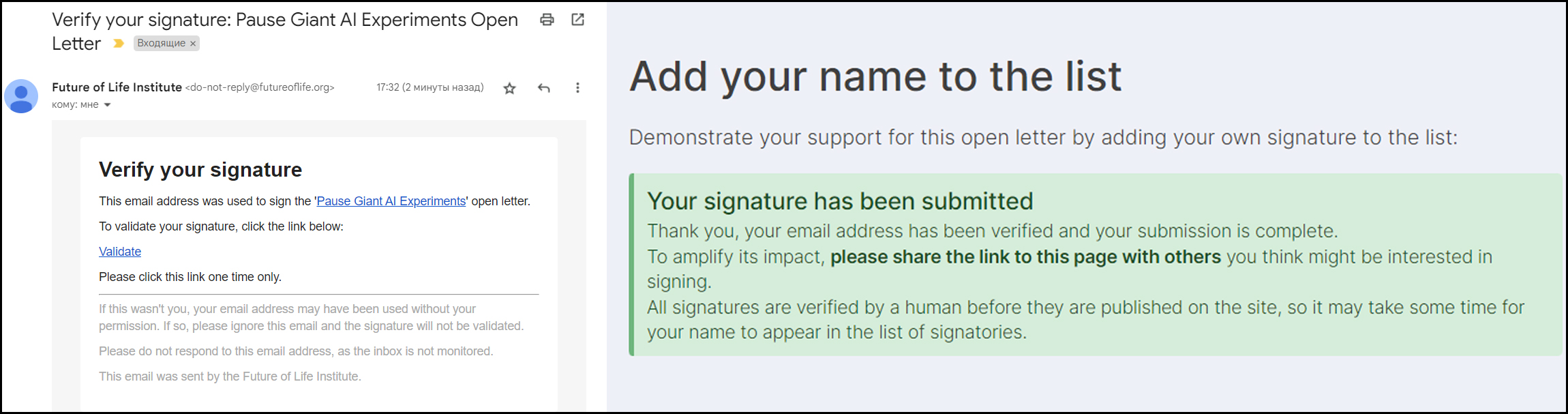

Подписать письмо за приостановку развития ИИ и введение регуляции может любой желающий. Для этого в конце письма нужно оставить свои персональные данные на английском и верифицировать подпись по электронной почте.

Выборка мнений известных людей о рисках развития ИИ

Некоторых разработчиков письмо разозлило — например, CEO Pershing Square Билл Экман посчитал, что пауза разработки ИИ даст «плохим парням» (конкурентам) время сократить разрыв между их кустарными ИИ и «официальными» системами.

CEO Google Сундар Пичай хоть и поддержал авторов письма, но при этом заявил, что не считает возможным остановку развития ИИ в данный момент:

Может ли искусственный интеллект угрожать человечеству? Вполне. У него огромный спектр возможностей, так что угроза тоже туда входит. Письмо — хороший шаг для старта диалога по этому поводу, но я не вижу, как компании смогут коллективно реализовать предложенные там решения самостоятель. Смотрите: если я разошлю своим инженерам письмо о том, чтобы они перестали развивать ИИ — разве это гарантирует, что другие компании поступят так же? Конечно, нет. Поэтому подобные решения должны принимать и реализовывать власти. И, скорее всего, это займёт немало времени, в течение которого появятся новые риски — и их тоже нужно будет как-то решать.

Игорь Курганов поддержал идею с замедлением развития ИИ: по его мнению, продолжать выпускать всё более мощные системы, которые люди не могут контролировать — это очень глупая идея. Он также привлёк внимание к заявлению бывшего разработчика OpenAI Ричарда Нго:

Мир находится на пути к развёртыванию миллионов сверхчеловеческих искусственных интеллектов. Но текущие методы их обучения дают им прямые и косвенные стимулы к обману людей и манипулированию ими. И при этом мы не можем предсказать, как они будут это делать, потому что ИИ часто развивают удивительные и неожиданные способности.

Лив Бори обсудила риски ИИ с основателем центра исследований «The Consilience Project» Даниэлем Шмахтенбергером — в видео на Ютубе он поделился своим видением проблемы с позиции человека, который не является разработчиком, но работает в сфере науки:

Искусственный интеллект обладает способностью оптимизировать практически что угодно — и это главная проблема на мой взгляд. Например, он может сделать добро — оптимизировать линии поставок снабжения для какой-то территории, но также может сделать и зло — оптимизировать террористические атаки на них. При этом для него между этими действиями фактически не будет разницы.

Кроме того, разработка ИИ требует огромных затрат ресурсов и денег, что доступно немногим, но как только удаётся выпустить модель работающей системы и она попадает в сеть — любой человек со своими намерениями может использовать её с минимальными затратами. В такой ситуации ни о какой безопасности речи идти не может в принципе.

Даниэль Негреану указал на ещё одну перспективную проблему, связанную с повсеместной доступностью ИИ и отсутствием контроля за ним:

Как скоро мы придём к тому, что звёзды или политики, пойманные на видео или аудио за неподобающим поведением, будут использовать для защиты утверждение о том, что это фейк, созданный ИИ? Кажется, это выглядит вполне вероятной причиной для заявления о невиновности.

Какие риски развитие ИИ несёт для человечества?

Если обобщить информацию из письма, мнения людей из Твиттера и различных экспертов, то можно выделить пять общих рисков развития систем искусственного интеллекта:

Лишение людей работы, которую может выполнять ИИ. В отличие от индустриализации, которая принесла человечеству новые способы работы, искусственный интеллект не даёт ничего нового, а просто решает задачи оптимальным путём. Его дальнейшее развитие может привести к автоматизации всех процессов производства, что увеличит число безработных. При этом с очень высокой вероятность ИИ будет развиваться быстрее, чем общество будет создавать новые профессии и виды работ. Это может обернуться тем, что незатронутые ИИ сферы будут переполнены желающими работать, но вакансий для них будет не хватать — тогда компании смогут сильно снижать оплату труда, пользуясь сокращением альтернатив для трудоустройства и содержания себя. Население в общем будет беднеть, а небольшая прослойка — экстенсивно богатеть, что резко увеличит расслоение общества.

Смещение мотивации при принятии решений из морально-эмпатического спектра в рационально-математический. Использование ИИ для решения проблем социума и морально-этических дилемм может привести к дегуманизации человечества. Запрограммированная человеком система блестяще мыслит в категориях рационального и оптимального, но лишена чувств и ощущений, а значит не испытывает угрызений совести и моральных страданий — решения она принимает без учёта справедливости или честности.

Снижение среднего уровня образованности населения. В 2023 году Российский государственный гуманитарный университет подарил мировому сообществу тревожный прецедент: его студент Александр Жадан за 23 часа написал диплом с помощью ChatGPT и смог защитить его. И хотя нейросеть не смогла в процессе работы осилить методичку университета — объём в 100 страниц оказался слишком большим — мировое научное сообщество получило сигнал, что доступность ИИ избавляет население от необходимости думать и изучать что-то самостоятельно. В перспективе, любое написание работ студентами может стать бессмысленным, поскольку проверить, был ли для этого использован усовершенствованный ИИ или нет, может быть просто невозможно. Не стоит забывать и про дезинформацию общества, ведь ИИ учится на общедоступных данных человечества, а люди в большом объёме генерируют псевдонаучные, эзотерические, пропагандистские и прочие недостоверные материалы и фейки. Один из ярких примеров начала 2023 года — фейковые фотографии Папы Римского, задержания Трампа или Байдена, из-за популярности которых сервис генерации картинок Midjourney даже вынужден был прекратить бесплатное предоставление услуг.

Обесценивание искусства, литературы и музыки, а также уничтожение авторского права. Некоторые нейросети уже справляются с написанием текстов, генерацией изображений и музыкальных треков. Конечно, в них нет авторской задумки, но по мере развития ИИ может случиться так, что системы будут генерировать настолько качественные продукты, что людские старания по их созданию потеряют свою ценность.

Взрывной рост мошенничества. Это уже происходит — например, в 2022 году имитирующий голос ИИ был использован преступниками для обмана людей в США на сумму свыше $11M. С текущими темпами развития технологий вероятность невозможности распознавать мошенников с ИИ и их наказания будет только расти, а способы защиты от них будут успешно разрешаться самой системой.

Чем искусственный интеллект полезен для человечества?

Главный плюс искусственного интеллекта — экономия времени людей. Он способен быстрее обрабатывать данные и в большем объёме, чем человек, при этом даже на текущем этапе ему удаётся выдавать продукты этой обработки в достаточном качестве для того, чтобы людям не нужно было тратить время на детальную проверку. Это касается в первую очередь решения задач, где нужно найти оптимальное решение, генерации текстов, картинок и музыки по ТЗ, когда от автора не требуется творческое самовыражение, а также поиска логических или фактических ошибок в текстах.

Выработка оптимальных рациональных решений — это второй плюс ИИ. Нейросеть нельзя запугать или иначе заставить делать что-то, что не прописано в её алгоритмах. Она не подвержена влиянию эмоций, её нельзя разжалобить или убедить в чём-то, поэтому она принимает решения, которые не только учитывают все необходимые факторы, но и являются на 100% рациональными. Тогда как для морально-этических вопросов это плохо, для решения технических проблем — например, инфраструктурных или логистических — такой подход крайне полезен.

Некоторые разработчики также выделяют плюсом отсутствие когнитивных ошибок. Поскольку ИИ не мыслит в полном смысле — у него нет мозга со всеми его физиологическими и психическими причудами — то и выводы, сделанные им, лишены аффилированных рисков. В некоторой степени противовесом этому плюсу является вероятность ошибки в коде — ИИ кодируется человеком, а значит может содержать ошибку, о которой не будет подозревать, поскольку он так закодирован, то есть его выводы будут приняты с учётом технической ошибки.

Наконец, ИИ способен прогнозировать события на основе опыта прошлых лет и текущего положения дел. За счёт этого социум может получать рекомендации по дальнейшим действиям для подготовки к каким-то событиям или недопущения их возникновения.

Несёт ли развитие ИИ риски для покера?

30 марта 2023 покерист, основатель RunItOne Фил Гальфонд, который много лет работает с покерным ИИ-софтом, выпустил на своём канале видео с названием «Убьёт ли ИИ покер?» (Is AI Killing Poker?). В этом видео Фил делает три интересных вывода:

Солверы с ИИ ничем не угрожают покеру. Хотя они и способствуют улучшению уровня вашей игры, они по факту лишь дают понимание оптимальных линий, но не способны научить играть идеально против всех индивидуальных особенностей оппонентов.

Человек физически не способен запомнить все солверные стратегии — комбинаций возможных рук, флопов, тёрнов, риверов, бордов в целом, ваших действий и действий оппонентов слишком много, они различаются между дисциплинами и форматами игры. Даже если вы сможете использовать солвер непосредственно во время игры — а это уже давно запрещено онлайн-румами — вам не будет хватать времени для внесения всей информации по раздаче и проведения расчётов, особенно в мультивеях.

Боты меньше угрожают покеру, чем подсказчики (RTA). Для кого-то это может звучать контринтуитивно, но это факт. RTA не играет сам, а используется человеком при принятии решений. Бот играет сам по себе, причём ведёт себя за столом довольно типично, а это позволяет румам его вычислить. Зачастую ботов запускают в румы группами, за счёт чего они в том числе и обнаруживаются — группа игроков, которые имеют почти идентичные статы, играют по определённому расписанию, используют общие данные для верификации и так далее — лёгкая добыча для службы безопасности.

Использование румами ИИ для поиска мошенников с ИИ снижает риски. Покерными румами управляют достаточно умные люди. Во-первых, они понимают, что наличие «идеальных» игроков негативно влияет на репутации компании и отталкивает любителей от неё. Во-вторых, они следят за передовыми разработками в сфере покера и знают, с чем им приходится бороться. В некоторой степени между мошенниками и СБ румов происходит постоянная «гонка ИИ-вооружений», которая не затрагивает большую часть игроков.

Фил также поделился в своём видео неожиданным фактом. По его словам, от 70% до 90% всех игроков рума — количество зависит от его популярности и уровня регуляции — играют в ноль или минус. В такой ситуации службе безопасности нет смысла тратить ресурсы на контроль основной массы игроков, поэтому она следит за оставшимся 30% — 10% поля, уделяя особое внимание тем, кто стабильно играет в плюс и при этом имеет подозрительные статы на дистанции.

Так является ли ИИ настоящей угрозой?

С учётом того, что системы искусственного интеллекта никак не регулируются, но при этом уже способны создавать дипфейки, дезинформировать людей и выдавать оптимальные решения для социально опасных действий, кажется, что на данном этапе вреда от них гораздо больше, чем пользы.

Если контроль разработки, применения и общедоступности ИИ не будет усилен, он действительно имеет высокие шансы стать угрозой номер один для людей — собственно, поэтому Илон Маск и другие энтузиасты техносферы забили тревогу по поводу слишком быстрого развития нейросетей.

Однако, если разработчикам и правительствам стран удастся наладить регуляцию и привести технологию ИИ к точке, где она будет безобидна и безопасна для людей, но при этом достоверна и функциональна, мы с высокой вероятностью войдём в эпоху, где организация работы и жизни будет кардинально отличаться от текущих в пользу более качественного распределения времени и ресурсов.

Ищите другие статьи спецпроекта ПокерОК и Покерофф по тегу #Спецпроект ПокерОК под статьёй. Больше крутых новостей и материалов ждут вас в Телеграм-канале Покерофф.